Temporal-difference(TD)learning是MonteCarlo(MC)ideas和dyn...

6.1 TD Prediction

在every-visit MC methods中,更新value funtion: 是step-size parameter,此方法称为constant-

method。MC等一个episode结束,得到

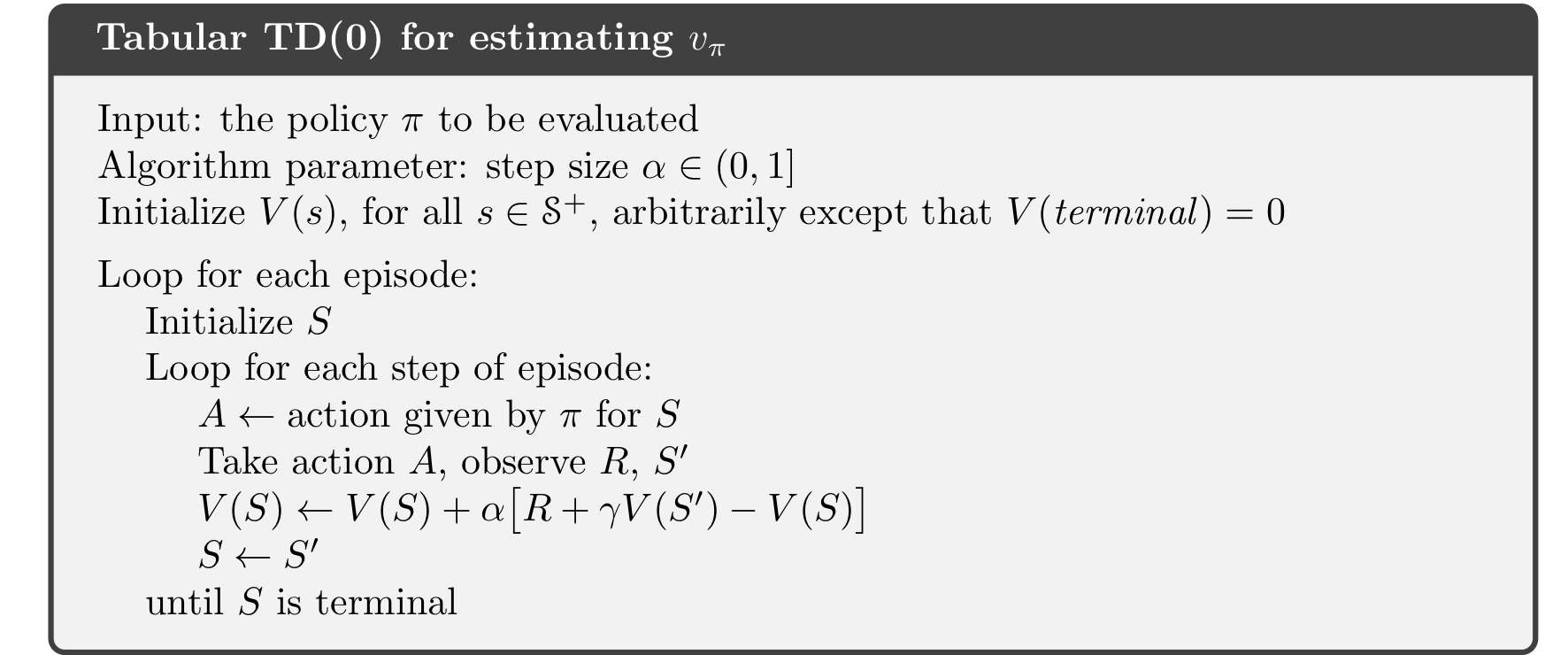

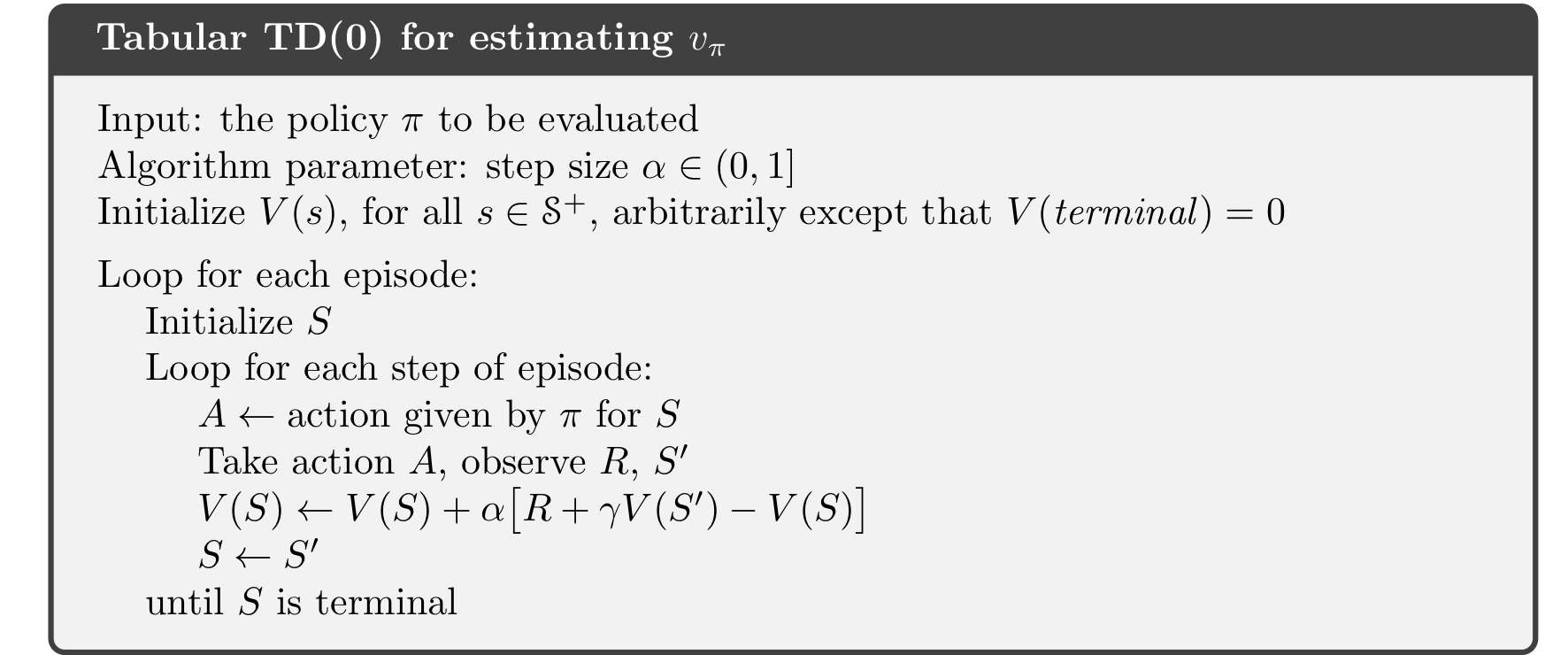

后更新value funtion。而TD方法只需要等下一步:

MC 用 ,TD用

。这种方法称为TD(0),或者one-step TD,是TD(

)的特殊形式

由chapter 3得

由chapter 3得

6.2 Advantages of TD Prediction Methods

TD比MC和DP优于何处,本书之后的部分都是回答这个问题。很明显,不像DP需要dynamics model。不像MC需要等一个episode,这经常是关键因素。MC中走一个随机的step后,很可能一个episode都需要弃掉,学起来很慢。已经证明TD(0)可以收敛到正确结果,若step size逐渐减小,满足(2.6)。虽然大部分都是对于table-based case,但有的也可以用于linear function approximation。TD、MC都能保证收敛,那么哪个更快?这仍是一个open question,但一般情况下在stochastic任务中,TD methods比constant-本文标题: Intro to RL Chapter 6: Temporal-Difference Learning

本文地址: http://www.lzmy123.com/duhougan/142879.html

如果认为本文对您有所帮助请赞助本站