MonteCarlomethods不要求对环境的信息,而是从真实的experience中学习(state,action,...

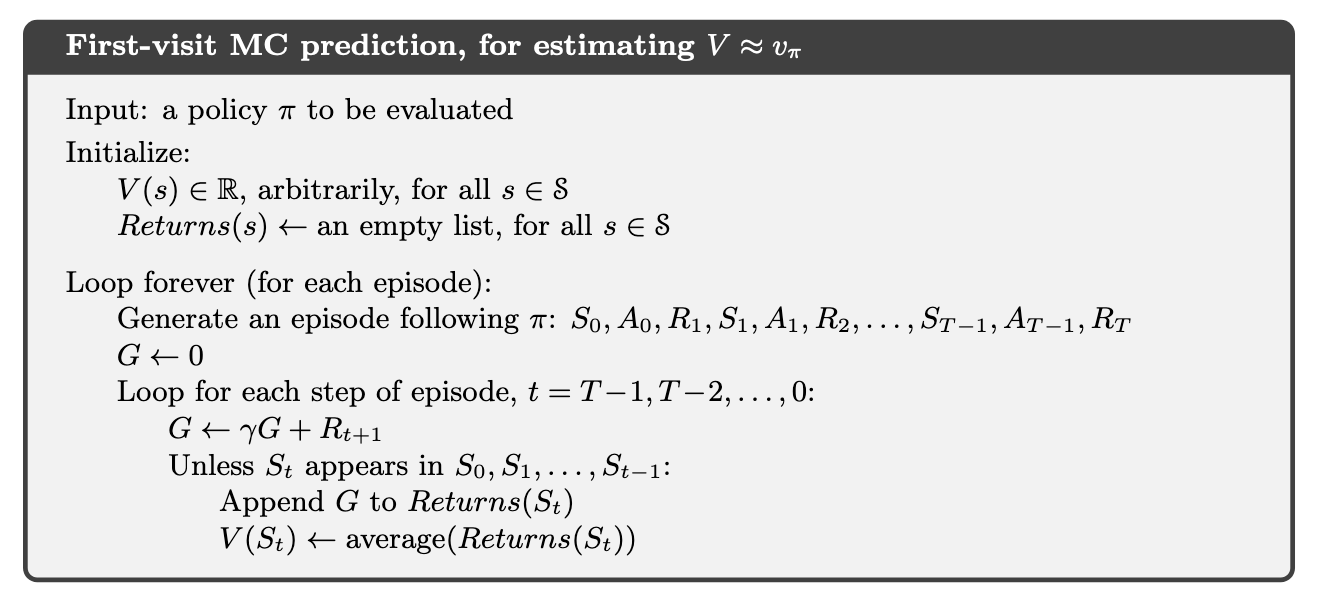

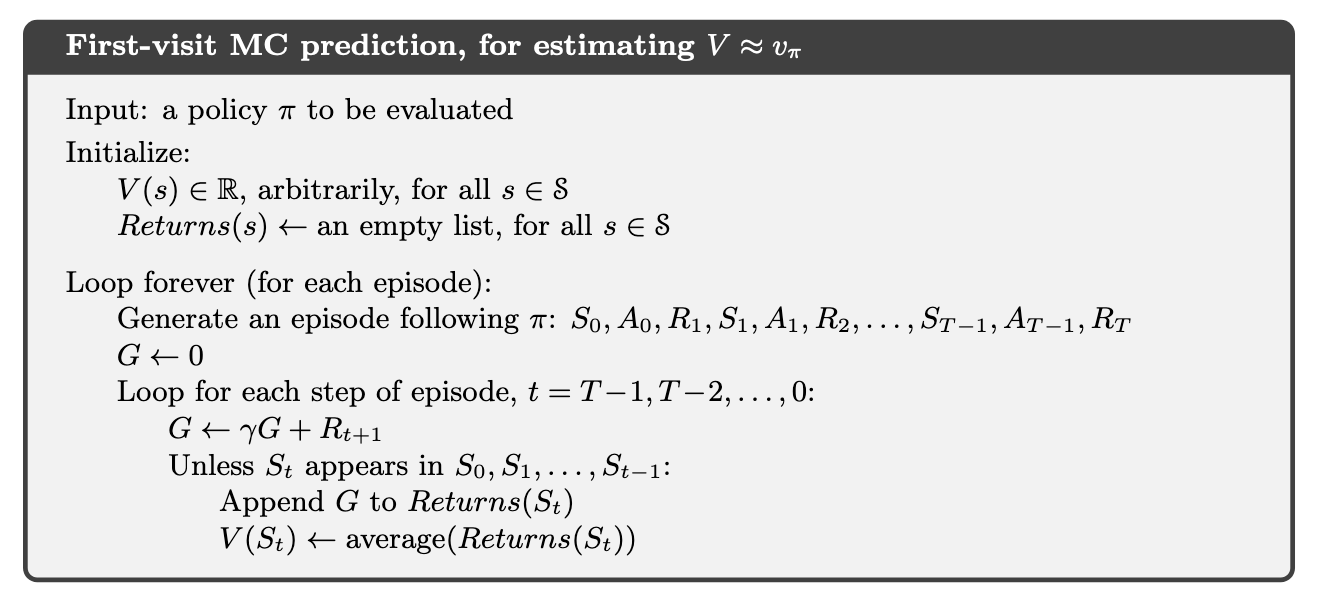

5.1 Monte Carlo Prediction

首先考虑state-value function。Monte Carlo methods从experience中计算平均state value,sample越多,更趋近于真实值。比如

当visit数趋于

当visit数趋于 5.2 Monte Carlo Estimation of Action Values

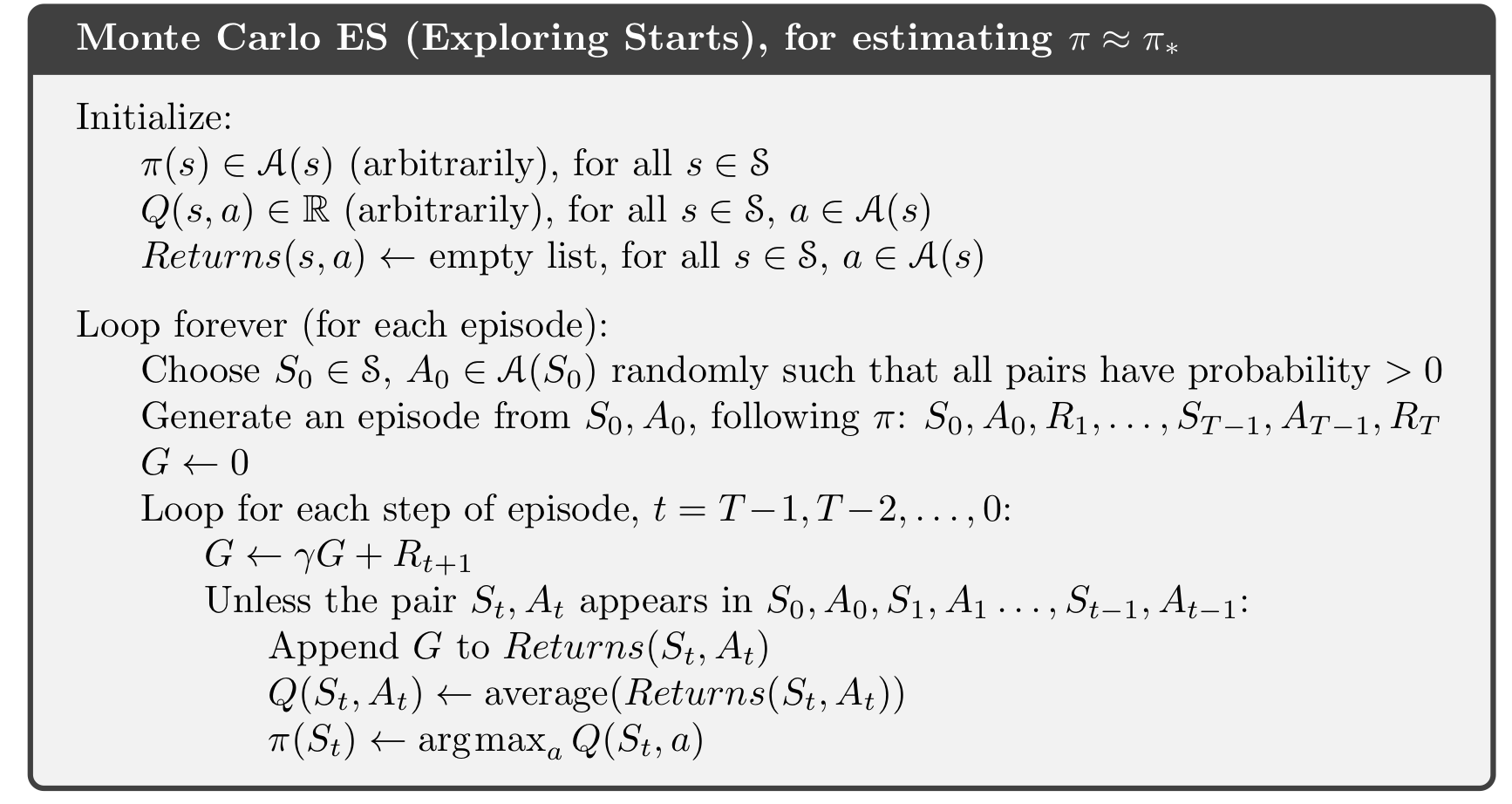

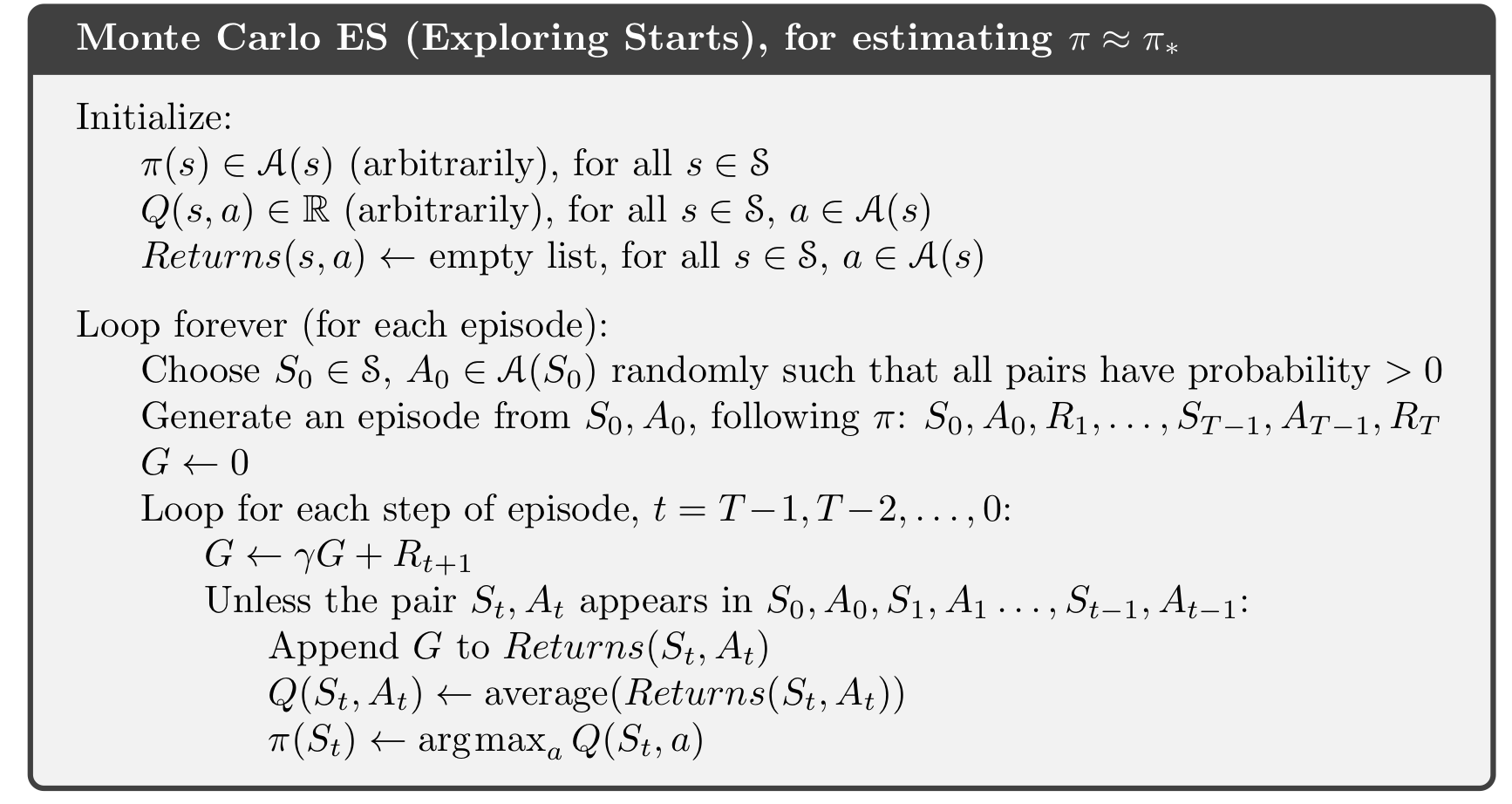

若model未知,action value比state value 有用,毕竟单靠state value不能确定policy。估计action value和估计state value的方法一样。若policy是deterministic,那么很多state-action都没有被选择,我们不知道这些pair的action value,也就无法update policy。这是一个maintaining exploration的问题。一个解决办法是从所有state-action pair都开始一次,当sample无限次,每个pair都被经历无限次,称为exploring starts。更常见的方法是用stochastic policy,每一个action的概率都不为0。5.3 Monte Carlo Control

有了state value和action value,就可以找到policy了。方法和DP一样,都是用generalized policy iteration (GPI) 方法:policy evaluation + policy improvement。用action value来选择policy,用exploring starts方法保证exploration:

在Monte Carlo ES中,不论是什么policy的action value,都被存下来计算。很明显Monte Carlo ES不converge到suboptimal policy,只有到optimal的时候才stabilize。convergence看起来是必然的,但是未被证明过,这是一个RL问题中一个很基础的开放问题。

在Monte Carlo ES中,不论是什么policy的action value,都被存下来计算。很明显Monte Carlo ES不converge到suboptimal policy,只有到optimal的时候才stabilize。convergence看起来是必然的,但是未被证明过,这是一个RL问题中一个很基础的开放问题。5.4 Monte Carlo Control without Exploting Starts

本文标题: Intro to RL Chapter 5: Mante Carlo Methods

本文地址: http://www.lzmy123.com/duhougan/139244.html

如果认为本文对您有所帮助请赞助本站